SEO対策に取り組む中で「もっと手早く結果を出したい」という焦りから、ガイドラインに反する手法に手を出してしまうケースは後を絶ちません。しかし、そうした近道は一時的な効果があったとしても、最終的にはGoogleからの厳しいペナルティという形で代償を支払うことになります。この記事では、私、柏崎剛がSEOの現場で20年以上にわたり見てきた「絶対にやってはいけないSEO施策」を具体的に解説し、なぜそれらが危険なのか、もしペナルティを受けてしまった場合にどう対処すべきかをお伝えします。正しい知識を持っていれば、こうした落とし穴を事前に回避できます。焦りや誤った情報に惑わされず、地に足のついたSEO戦略を築くための参考にしていただければ幸いです。

Googleのスパムポリシー違反がもたらす深刻な代償

Googleは「Google検索の基本事項」において、スパムポリシーに違反するサイトに対して検索結果での掲載順位の大幅な引き下げや、インデックスからの完全な除外という措置を取ることを明確に示しています。この措置の影響は想像以上に深刻です。自然検索からのアクセスがほぼゼロになり、事業の売上に直接的な打撃を与えることも珍しくありません。しかも一度ペナルティを受けると、原因となった問題を修正した後も回復までに数か月から年単位の時間を要することがあります。SEOの成果を急いだ結果、サイトそのものの信頼性を根底から失ってしまう事例を、私は現場で数えきれないほど目にしてきました。

Googleがスパム対策にどれほど本気で取り組んでいるかは、その検知規模からも明らかです。Google Search Central Blogの公式レポートによると、1日あたりに検知されるスパムページ数は2019年の約250億ページから2020年には約400億ページへと大幅に増加しています。それでも検索結果の99%以上がスパムフリーに保たれているのは、SpamBrainをはじめとするAIベースの検知システムが常に進化を続けているからです。

ここで押さえておきたいのは、Googleのスパムポリシーは年々更新されているということです。数年前までは問題にならなかった手法が、最新のポリシー改定によって違反とみなされるケースも増えています。「以前は大丈夫だったから」という過去の成功体験に頼ることは、現在のSEOにおいては非常にリスクの高い考え方です。また、ペナルティを受けるのは大規模サイトだけだと思い込んでいる方もいますが、実際には小規模な個人ブログや中小企業のサイトであっても、スパム行為が確認されれば例外なく措置の対象になります。サイトの規模にかかわらず、Googleのガイドラインを遵守する姿勢がSEOの出発点です。

キーワードの不自然な詰め込みが逆効果になる理由

ターゲットキーワードをページ内に大量に配置すれば検索順位が上がるという考え方は、現在では完全に通用しません。Googleのアルゴリズムは文章の自然さを非常に高い精度で判定できるようになっており、タイトルタグや見出し、本文中に同じキーワードを不自然に繰り返す「キーワードスタッフィング」は、スパム行為として即座に検知されます。かつてはキーワード出現率を一定の割合に保つことがSEOの定石とされていた時代もありましたが、その手法はすでに過去のものです。現在のGoogleは文脈や文意を理解する能力を持っているため、キーワードそのものよりも、そのキーワードが指し示すトピックについてどれだけ深く正確に書かれているかを評価しています。

過剰最適化が検知される具体的なパターン

Googleが特に問題視している過剰最適化のパターンには、以下のようなものがあります。

- フッターやサイドバーへのキーワード羅列

コンテンツ本文とは無関係に、ページの周辺領域にキーワードを大量に詰め込む手法で、スパムアップデートの主要な検知対象となっている - 画像alt属性への無関係なキーワード設定

画像の内容を説明する本来の目的から外れ、検索順位を狙ったキーワードをalt属性に設定する行為 - メタディスクリプションやURLパスへの過剰挿入

メタディスクリプションにキーワードを不自然に繰り返したり、URLのパスにキーワードを何重にも入れたりする手法 - 同義語や関連語の過度な散りばめ

ページ全体にわたって関連語を不自然なほど多用する手法で、最近のアップデートで検出精度が大幅に向上している

私のコンサルティング経験上、キーワードの出現率を人為的に操作するよりも、読者が抱える疑問に対して真正面から答える文章を丁寧に書くほうが、はるかに安定した検索順位を長期的に維持できています。

キーワード密度の人為的な調整ではなく、トピックに対する意味的なカバレッジを高めるには、そのキーワードが実際にどのような語彙と共起しているかを品詞レベルで把握することが有効です。形態素解析エンジンMeCabを搭載した以下のツールでは、共起語の品詞細分類・活用形・原形まで分析でき、検索エンジンが「このトピックについて十分に書かれている」と判断するための語彙構成を客観的に確認できます。

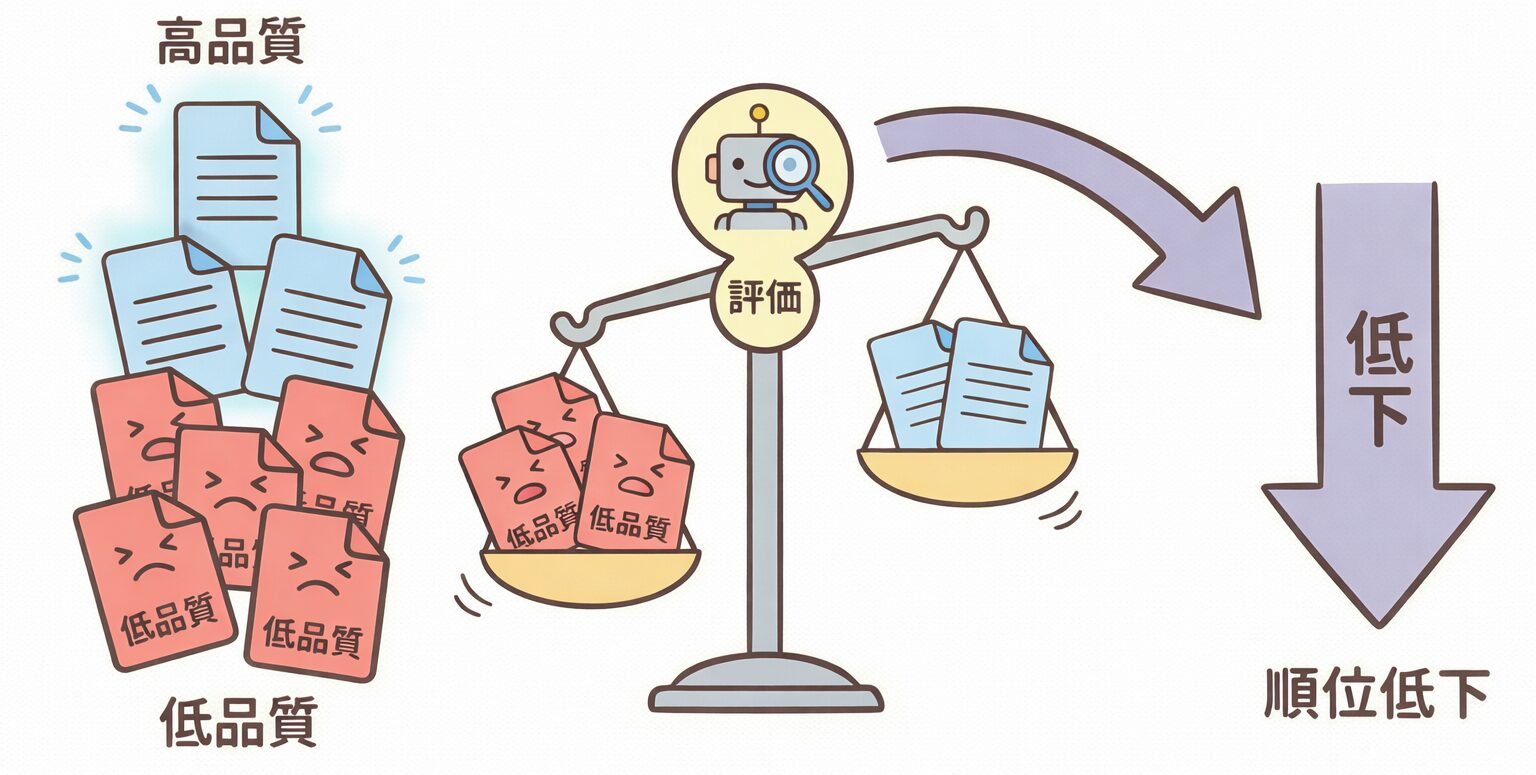

低品質コンテンツの量産がサイト全体の評価を引き下げる

検索からの流入を増やすためにとにかく記事の本数を増やすという戦略は、一見すると合理的に思えるかもしれません。しかし、内容の薄い記事や他サイトの情報を切り貼りしただけの記事を量産することは、Googleのコアランキングシステムに組み込まれたヘルプフルコンテンツの評価基準(旧ヘルプフルコンテンツシステム、2024年3月にコアランキングへ統合)によってサイト全体の評価を押し下げる原因になります。この仕組みはサイト単位で品質を評価するため、低品質なページの割合が一定水準を超えると、質の高いページまで道連れになって順位が下落するという深刻な影響をもたらします。

特に注意すべきなのは、過去に公開した古い記事が放置されているケースです。情報が陳腐化したまま更新されていない記事も低品質コンテンツとみなされるため、新規投稿だけでなく既存記事の品質維持にも目を配る必要があります。

AIで大量生成した記事をそのまま公開するリスク

生成AIの急速な普及により、短時間で大量の記事を作成できるようになりました。しかしAIが出力した文章をそのまま無編集で公開するのは、SEOの観点から見ても大きなリスクを抱えています。Googleは「コンテンツの作成方法よりも品質を重視する」と公式に述べていますが、独自の知見や実体験を一切加えていないAI生成コンテンツは、検索意図を表面的にしか満たせず低品質と判断される傾向にあります。実際に、AI記事を数百ページ規模で一気に投入したサイトが、インデックスの大幅な縮小と順位の急落に見舞われた事例を私は複数確認しています。AIを活用すること自体が問題なのではなく、人間の専門知識による検証と独自の視点を加えずにそのまま公開してしまうことが問題の本質です。

被リンクの購入や自作自演が発覚したときの末路

外部サイトからのリンクが検索順位の評価要素であることは広く知られていますが、リンクを金銭で購入したり、自ら作成した複数のサイトからリンクを張る自作自演は、Googleが最も厳しく取り締まっている違反行為です。こうしたリンクスキームが発覚すると、対象サイトに対して手動対策が課されるだけでなく、リンク元のサイトも同時にペナルティの対象となることがあります。投資したコストが完全に無駄になるだけでなく、本来積み上げてきた正当な評価まで失われてしまう可能性がある点を認識しておく必要があります。さらに問題なのは、リンク購入業者がペナルティのリスクを依頼者に十分に説明しないまま契約を結ぶケースが多いことです。「安全なリンク」「Googleに検知されないリンク」といった謳い文句は信用してはいけません。

リンクスパム検知の精度が年々高まっている

GoogleはSpamBrainと呼ばれるAIベースのスパム検知システムを本格運用しており、リンクの不自然なパターンを極めて高い精度で見抜くようになっています。SpamBrainが総合的に分析する主なシグナルは次のとおりです。

- リンク元サイトとの主題の関連性

自サイトのテーマとまったく無関係なサイトからのリンクは、不自然なリンクとして高い確度で検知される - 短期間での被リンク数の急増

自然な被リンク獲得では起こりにくい急激な増加パターンは、リンク購入やPBNの典型的な特徴として検出される - 特定のアンカーテキストへの偏り

同一のキーワードを含むアンカーテキストが不自然に集中している場合、操作されたリンクと判断される可能性が高い

かつては発見を免れることができたPBN(プライベートブログネットワーク)も、現在のSpamBrainの前では通用しなくなっています。相互リンクの過度な構築や、寄稿記事を装ったリンク挿入なども検知の対象に含まれており、自然なリンク獲得以外のほぼすべてのリンク構築手法がリスクを伴う時代になっています。

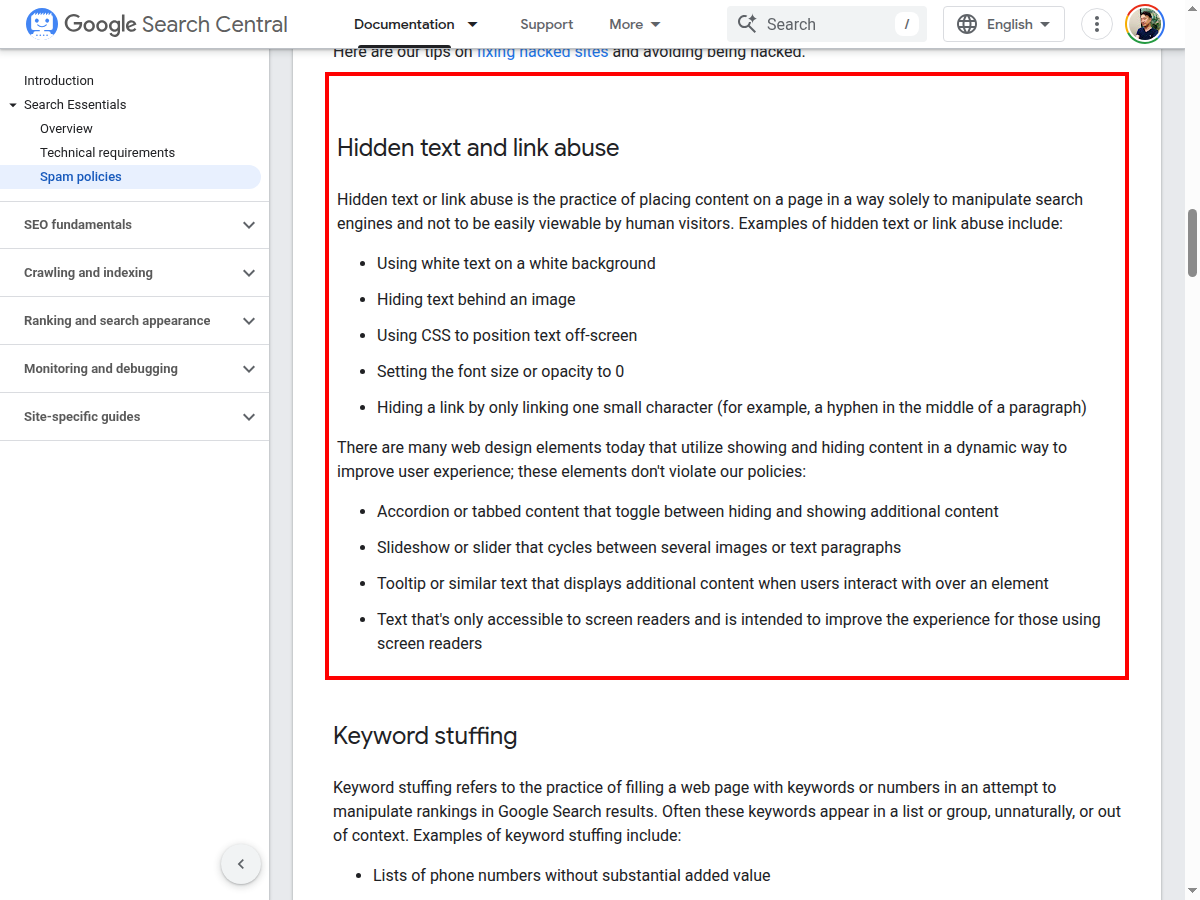

隠しテキストやクローキングが確実に検出される理由

背景色と同じ色の文字でキーワードを大量に埋め込む「隠しテキスト」や、Googleのクローラーとユーザーのブラウザに異なるコンテンツを表示する「クローキング」は、SEOの黎明期から存在する古典的なスパム手法です。これらが現在でも通用すると考えるのは大きな間違いです。Googleは高度なレンダリングエンジンを用いてページをブラウザと同じように描画し、視覚的に見えないテキストやコンテンツの出し分けを精密に検出しています。CSSのdisplay:noneやvisibility:hidden、フォントサイズをゼロに設定する手法、さらにはJavaScriptを使った動的な出し分けまで、あらゆるパターンが検知対象です。発覚した場合はインデックスからの完全な削除という最も重い措置が科される可能性が高く、回復は極めて困難です。

Googleが検出対象としている隠しテキストの主なCSSパターンは以下のとおりです。

/* Googleが検出する隠しテキストのCSS手法(すべてスパムポリシー違反) */

.hidden { display: none; }

.hidden { visibility: hidden; }

.hidden { font-size: 0; }

.hidden { color: #ffffff; background-color: #ffffff; }

.hidden { position: absolute; left: -9999px; }Googleの公式スパムポリシーでも、隠しテキストやクローキングは明確に禁止行為として定義されています。

近年ではユーザーエージェントの切り替えによる出し分けだけでなく、IPアドレスベースでの表示切り替えも検出できるようになっており、クローキングが成功する余地はほぼ残されていません。こうした手法に一度でも手を出してしまうと、サイトの信頼スコアが大きく毀損され、たとえ問題箇所を修正したとしてもGoogleからの信頼を取り戻すまでに非常に長い時間がかかります。古典的な手法であるがゆえに「もう誰もやっていないだろう」と思いがちですが、意図せずテーマやプラグインの設定でクローキングに近い状態になってしまっているケースも存在するため、自サイトの出力状態を一度確認しておくことをおすすめします。

リダイレクトやcanonical設定の誤りが検索評価を分散させる

悪意のあるスパム行為ではなくても、技術的な設定ミスがSEOに深刻なダメージを与えることがあります。その代表例がリダイレクトとcanonicalタグの誤設定です。特にリダイレクトについては、301と302の違いを正しく理解せずに設定してしまうケースが非常に多く見られます。

| 項目 | 301リダイレクト | 302リダイレクト |

|---|---|---|

| 転送の種類 | 恒久的な転送 | 一時的な転送 |

| SEO評価の移行 | 旧URLの評価が新URLに引き継がれる | 評価が正しく移行されないことがある |

| 適切な使用場面 | URL変更やドメイン移転 | メンテナンス時の一時的な転送 |

| 誤用時のリスク | 低い | 評価の分散や順位の不安定化 |

本来301リダイレクトを設定すべきところで302を使ってしまうと、旧URLに蓄積されていた評価が新URLに正しく移行せず、検索順位が不安定になります。またcanonicalタグを誤って無関係なページに向けてしまうと、正規ページがインデックスから除外されるという事態に陥ることもあります。これらは意図的な不正ではないものの、放置するとサイト全体の検索パフォーマンスが大きく低下します。特にサイトリニューアルやドメイン移転の際にリダイレクト設定を一括で行う場面では、一つの設定ミスが数百ページに波及する危険性があるため慎重な確認作業が求められます。Search Consoleの「ページのインデックス登録」レポートを定期的に確認して設定エラーを早期発見する運用体制を整えておくことが不可欠です。加えて、wwwの有無やHTTPとHTTPSの混在といったURL正規化の問題も、canonicalやリダイレクトの設定漏れから生じやすいため、サイト全体のURL構造を一元的に管理する仕組みを構築しておくと安心です。技術的なミスは悪意がなくてもSEOに与えるダメージは同じですので、定期的な技術監査を実施して問題の芽を早い段階で摘み取ることが望まれます。

サイト移転やURL変更の際は、以下のように正しい301リダイレクトを設定しましょう。

# .htaccess での301リダイレクト設定例

# 個別ページのリダイレクト

Redirect 301 /old-page/ https://example.com/new-page/

# 正規表現による一括リダイレクト

RewriteEngine On

RewriteRule ^old-directory/(.*)$ /new-directory/$1 [R=301,L]

# HTTPからHTTPSへの統一

RewriteCond %{HTTPS} off

RewriteRule ^(.*)$ https://%{HTTP_HOST}%{REQUEST_URI} [R=301,L]canonicalタグの正しい設定方法も確認しておくと、URL正規化の問題を未然に防ぐことができます。

<!-- canonicalタグの正しい設定例 -->

<link rel="canonical" href="https://example.com/correct-page/" />

<!-- wwwの有無を統一する場合 -->

<link rel="canonical" href="https://www.example.com/page/" />canonicalタグの手動管理では、投稿やカテゴリーアーカイブのページネーション(2ページ目以降)での設定漏れが見落とされがちです。以下のプラグインは投稿・固定ページ・カスタム投稿タイプに加えてアーカイブページのページネーションまでcanonical URLを一元制御でき、本文中で触れた「一つの設定ミスが数百ページに波及する」リスクを構造的に排除します。

ユーザー体験を無視したページ設計が順位を押し下げる仕組み

検索エンジン向けの最適化ばかりに力を注ぎ、ページを訪れるユーザーの閲覧体験をおろそかにしているサイトは、長期的に見て高い確率で順位低下につながります。Googleはユーザー行動のデータを検索品質の評価指標として間接的に活用しているため、以下のような問題を抱えるページは離脱率の上昇を通じて順位にマイナスの影響を受ける可能性があります。

- ファーストビューの大部分が広告で占められている

- 本題のコンテンツにたどり着くまでに長いスクロールが必要

- モバイル端末での表示が著しく崩れている

- 全画面を覆うポップアップが閲覧を妨げている

- 意図しない自動再生動画が配置されている

中でも見落としがちなのが、ページの読み込み速度とユーザー離脱の関係です。Googleとリサーチ企業SOASTAの共同調査によると、ページの読み込み時間が1秒から3秒に延びるだけで直帰率は32%上昇し、5秒まで延びると90%、6秒では106%にまで跳ね上がることが明らかになっています。

画像の最適化や不要なスクリプトの削減といった技術的な改善も欠かせません。SEOのためにコンテンツを増やすことばかりに気を取られて、ページそのものの使いやすさを軽視してしまうのは本末転倒です。検索エンジンが最終的に評価したいのは、ユーザーが満足するかどうかという点に集約されるため、ユーザー体験の向上はSEOと切り離して考えることができない関係にあります。

画像がページ速度を低下させている箇所を特定するには、個別の目視確認だけでは限界があります。以下のプラグインはサイト内の画像に対してalt属性の有無・ファイルサイズ・次世代フォーマット(WebP/AVIF)への対応状況を自動診断し、総合的な画像SEOスコアを算出します。直帰率の上昇を招く画像起因のボトルネックを体系的に洗い出す手段として有効です。

Googleペナルティの種類と解除までの道のり

Googleによるペナルティは大きく二種類に分けられます。それぞれ発動の仕組みや対処方法が異なるため、違いを正確に理解しておくことが回復への第一歩になります。

| 項目 | アルゴリズムによる影響 | 手動対策 |

|---|---|---|

| 発動の仕組み | コアアップデート等で自動的に適用 | Google品質評価チームが個別に審査 |

| 通知の有無 | なし(順位変動で気づく) | Search Consoleに通知が届く |

| 原因の特定 | 困難(具体的な理由は明示されない) | 違反の理由と対象範囲が表示される |

| 回復方法 | 改善後に次回のアルゴリズム更新を待つ | 修正後に再審査リクエストを送信する |

| 回復までの期間 | 数か月から年単位 | 審査完了後は比較的早い(数週間) |

アルゴリズムによる影響の場合は、どの要素が評価を下げているのかが明示されないため、原因の特定に時間がかかるケースが少なくありません。一方で手動対策を受けた場合はSearch Consoleに通知が届くため、問題を明確に把握することが可能です。どちらの場合でも共通して言えるのは、早期発見と迅速な対応が回復を早めるということです。

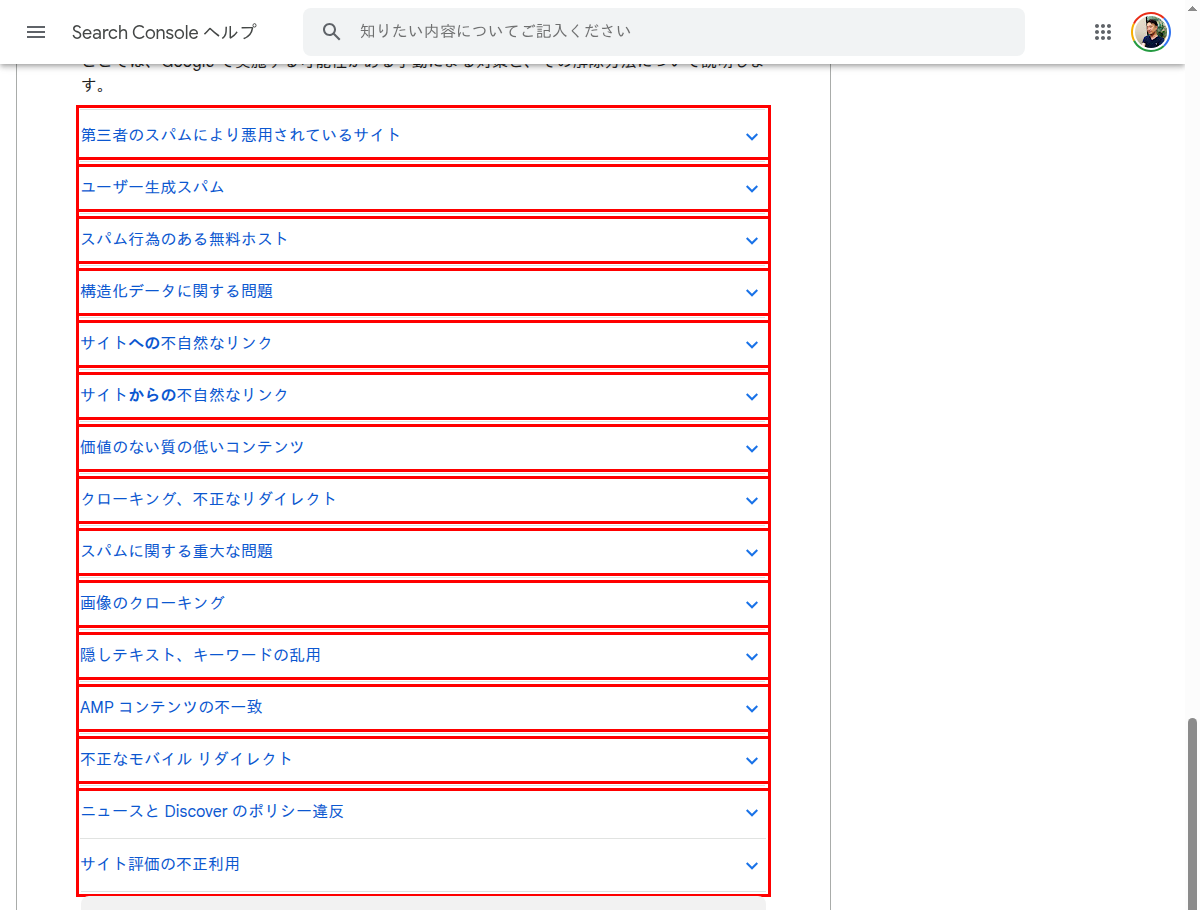

手動対策の確認から再審査リクエストまでの流れ

Search Consoleの「セキュリティと手動による対策」セクションを開くと、手動対策が課されているかどうかを確認できます。対策の内容と対象範囲が具体的に表示されるので、指摘された問題を一つずつ確実に修正していきます。不自然なリンクが原因の場合はリンク否認ツールを使って該当リンクを無効化し、コンテンツの品質が原因であれば対象ページの削除または大幅な書き直しを行います。

リンク否認ツールを使用する際は、以下の形式でテキストファイルを作成してSearch Consoleからアップロードします。

# リンク否認ファイルの記述例(disavow.txt)

# 個別URLを否認する場合

https://spam-site.example.com/link-page-1

https://spam-site.example.com/link-page-2

# ドメイン全体を否認する場合

domain:spam-domain1.example.com

domain:spam-domain2.example.comGoogleの公式ヘルプでは、手動対策の種類ごとに具体的な対処方法が解説されています。

修正が完了したら、実施した対策の内容を詳細に記載した再審査リクエストを送信します。このとき重要なのは、どのような違反があったのかを認識していること、具体的にどんな修正を行ったかを明記すること、そして再発防止のためにどのような体制を整えたかを説明することです。審査には通常数週間を要し、対応が不十分と判断された場合は追加の修正と再申請が必要になるため、焦らず丁寧に取り組むことが回復への最短ルートです。

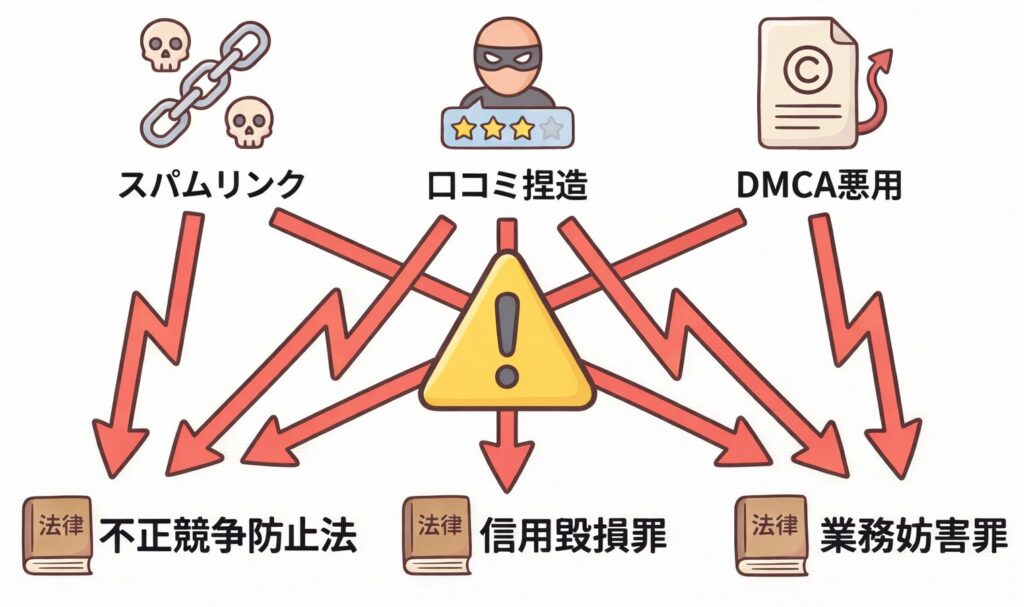

逆SEOの手口と法的リスクを正しく理解する

逆SEOとは、自社の順位を上げるのではなく競合サイトの検索順位を意図的に引き下げようとする行為を指します。具体的な手口としては、ターゲットのサイトにスパムリンクを大量に送りつける、ネガティブな口コミを捏造して複数のプラットフォームに拡散する、著作権侵害の虚偽報告であるDMCAテイクダウンを悪用するといったものがあります。これらの行為はGoogleのガイドラインへの違反にとどまらず、不正競争防止法や信用毀損罪、偽計業務妨害罪に該当する可能性があり、民事訴訟と刑事告発の両面で重大な法的リスクを伴います。

自分のサイトが逆SEOの被害に遭っていると感じた場合は、Search Consoleで不自然な被リンクの急増がないかを確認し、リンク否認ツールで対処することが基本的な防御策です。それでも被害が深刻な場合は、証拠を保全したうえで弁護士に相談し、法的措置を検討することも視野に入れるべきでしょう。なお、Googleは外部からの悪意あるリンク攻撃を自動的に無効化する仕組みを強化しているため、過度に心配する必要はないと公式に述べていますが、完全に防ぎきれるわけではありません。逆SEOのリスクを正しく認識しつつも、必要以上に恐れるのではなく、自サイトのコンテンツ品質とドメインの信頼性を地道に高めていくことが最も効果的な防御策になります。

NG施策をやめるだけでSEO効果は改善するのか

「やってはいけないSEO施策をすべてやめたら、それだけで検索順位は上がるのか」という問いに対する率直な答えは、「それだけでは十分ではない場合が多い」です。NG施策の停止は回復のための必要条件ではあるものの、それだけで十分とは言えません。特にアルゴリズムの影響を受けている場合、問題のあるコンテンツやリンクを除去してから実際に順位が回復するまでに数か月のタイムラグが生じることは珍しくありません。重要なのは、マイナス要素の排除と並行して、ユーザーに真に価値のあるコンテンツの制作やサイト構造の見直しといったプラスの施策に取り組むことです。マイナスをゼロに戻す作業とプラスを積み上げる作業を同時に進めることで、初めて持続的な順位回復と成長の基盤が築かれます。私がコンサルティングの現場でよく目にするのは、NG施策を排除した後に何をすべきかがわからず手が止まってしまうケースです。そのような場合こそ、ユーザーが本当に求めている情報は何かを改めて調査し、質の高いコンテンツを一つずつ着実に積み上げていくことが最善の道です。また、NG施策を行っていた期間が長ければ長いほど回復にも時間がかかる傾向にあります。半年や一年といったスパンで改善の推移を見守る忍耐力も、SEO回復には不可欠な要素です。回復の過程では、Search Consoleのデータを定期的にモニタリングし、改善傾向が確認できるかどうかを客観的に評価していくことが大切です。

信頼できるSEO情報を見極めるための判断基準

インターネット上にはSEOに関する情報が溢れていますが、古い情報や不正確な情報、意図的に読者を誤導する情報も数多く存在します。信頼できるSEO情報かどうかを判断するうえで、以下のポイントを確認する習慣を持つことが大切です。

- Google Search CentralやGoogleの公式ブログなどの一次情報に基づいているか

- 最新のアルゴリズムアップデートを反映した内容になっているか

- 具体的なデータや実証された事例に基づいた主張であるか

- 情報の発信元が実名を公開し具体的な実績を示しているか

「このテクニックで確実に1位を獲得できる」「知る人ぞ知る裏技で簡単に上位表示」といった過度な保証や煽り文句を使った情報は、ほぼ例外なく信頼に値しません。私が長年にわたりお伝えし続けているのは、SEOに魔法のような近道は存在しないということです。ユーザーにとって本当に価値のあるコンテンツを地道に作り続けること、これこそが「やってはいけないSEO」の対極にある最も確実で持続的な戦略です。怪しい情報に惑わされて遠回りをしないためにも、日頃からGoogleの公式情報に目を通す習慣を持ち、自分自身の情報リテラシーを高め、変化に対応できる判断力を養っていくことが重要です。